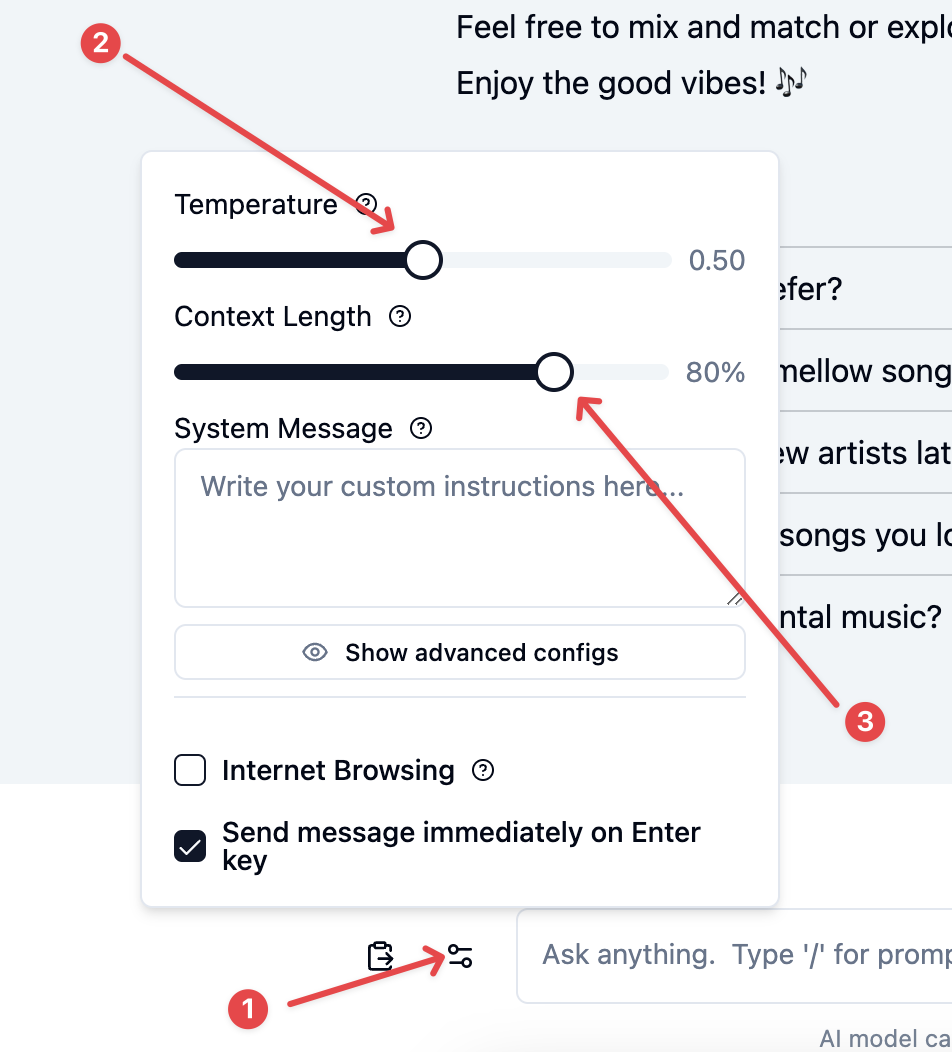

Temperature dan Context-Length

Temperature digunakan untuk mengontrol tingkat kerandoman jawaban dari AI. Temperatur yang lebih tinggi membuat model lebih kreatif dan sebaliknya jika temparature diset lebih rendah, akan lebih singkat, padat, jelas. Umumnya kita set default saja di 0.50 untuk menyeimbangkan antara kreatifitas dan kejelasan.

Context-Length

Mengontrol jumlah teks atau informasi yang diperhitungkan model saat memproses atau menghasilkan output. Semakin panjang Context-Length, semakin banyak informasi yang dapat digunakan model untuk menghasilkan respons yang koheren dan relevan.

Untuk penggunaan umum, kita biarkan nilai default saja yaitu 80%